Una aproximación básica a los conceptos y las técnicas de IA

La IA es un concepto sobre el que no existe una definición formal aceptada universalmente. No obstante, existen muchas aproximaciones que surgen de observar las definiciones encontradas en la web y publicaciones especializadas, a partir de las cuales es posible reunir algunas características comunes mencionadas con frecuencia para la IA: i) apreciar el contexto para establecer el marco de una tarea; ii) procesar datos estructurados y no estructurados sobre el problema en cuestión; iii) generar a partir de éstos un modelo de la realidad; y iv) predecir en base a este esquema un resultado relevante para el problema a resolver. En algunos casos, sobre este último punto se habla de toma de decisiones, aunque en realidad y a pesar del grado de autonomía de la IA, los resultados obtenidos por estos sistemas siempre deben quedar sujetos a la supervisión humana.

Si bien se trata de un campo en constante evolución que está definiendo nuevas formas de relación entre la técnica y los humanos, en forma más natural o intuitiva la Real Academia Española ha definido a la IA como «la disciplina científica que se ocupa de crear programas informáticos que ejecutan operaciones comparables a las que realiza la mente humana, como el aprendizaje o el razonamiento lógico.»

El Aprendizaje

Automático (AA) o Machine Learning es

una técnica que es un subconjunto de la IA, que enseña a las máquinas a

aprender de la experiencia sin una programación explícita. De este modo, los

algoritmos del AA se ejercitan por medio de métodos computacionales para

extraer información a partir de los datos, siendo una consecuencia lógica de la

aplicación de esta técnica, que los mismos se vayan perfeccionando en su

capacidad predictiva en la medida que se van alimentando con nuevos datos para

el aprendizaje.

A su vez el AA tiene dos variantes o ramas, una supervisada y la otra no supervisada. Con la primera el AA se entrena con datos de entrada y de salida que no son brutos sino que están etiquetados o preparados previamente, en tanto que con la segunda el entrenamiento de modelos de datos se hace sin procesar y sin etiquetar. El AA supervisado se utiliza para clasificar asignando con precisión a los datos de entrada categorías específicas, y para realizar análisis de regresión para establecer la relación entre variables dependientes e independientes. El AA no supervisado se emplea para agrupar datos que presenten similitudes y luego segmentarlos y separarlos por grupos para realizar análisis de datos preliminares. Esta variante tiene aplicaciones en la segmentación de imágenes para clasificar píxeles similares, facilitando la identificación de objetos y, en general, la interpretación de su contenido.

Una forma especializada del AA es el Aprendizaje Profundo (AP) o Deep Learning que utiliza Redes Neuronales. Es una tecnología que se inspira en la forma en que funciona el cerebro humano y que aprende empleando grandes volúmenes de datos o big data. Los algoritmos creados por el AP pueden detectar en forma autónoma información y patrones ocultos en los datos para entregar resultados en forma de predicción. Las principales diferencias entre el AA y el AP se muestran en la siguiente tabla:

|

Aspecto |

Aprendizaje

Automático |

Aprendizaje

Profundo |

|

Datos

de entrada u observados |

Opera con conjuntos

de datos pequeños |

Trabaja con grandes

volúmenes de datos |

|

Resolución

de problemas |

Requiere más

intervención humana para ajustes y correcciones. Se apoya en datos

estructurados (*). Los procesos y la selección de elementos necesitan

intervención humana y experiencia en el dominio de aplicación. |

Aprende

por sí mismo con base en la red neuronal. El proceso de extracción de

información es automatizado y maneja datos no estructurados (**). Las redes

aprenden a identificar características y patrones directamente a través de

los datos, reduciendo la necesidad de intervención humana. |

|

Interpretabilidad |

Más fácil de rastrear

y comprender el proceso de toma de decisiones. Los modelos de AA son más

transparentes, permitiendo una mayor interpretabilidad de cómo los datos de

entrada son convertidos en datos de salida o resultados. |

Conocido por ser una

«caja negra», por tratarse de modelos de entramado complejos, donde el

proceso de toma de decisiones no resulta fácilmente interpretable debido a

las múltiples capas y a la complejidad de la arquitectura. |

|

Tiempo

de entrenamiento |

Requiere un tiempo de

entrenamiento más corto, aunque arroja resultados de menor precisión |

Requiere un tiempo de

entrenamiento más largo y ofrece mayor precisión en los resultados |

|

Poder

computacional |

Necesita de escasos

recursos informáticos |

Necesita de una gran

capacidad de procesamiento |

Fuente: Basada en Chornyi, A. (2023)

Paralelamente al crecimiento exponencial de los datos en las últimas décadas, acompañado por una mayor capacidad de procesamiento informático y por herramientas y programas de tratamiento y análisis de datos, aplicaciones y plataformas, ha ido emergiendo una nueva disciplina como una respuesta para aprovechar el potencial de los mismos. Dicha área de conocimiento se conoce como Ciencia de los Datos que combina matemáticas y estadística, programación especializada, análisis avanzado, IA y AA con experiencia en temas específicos para descubrir conocimientos prácticos ocultos en los datos (IBM (a), s/f).

Áreas de aplicación

La aplicación de IA en el campo de los datos geoespaciales es conocida como IA geoespacial o GeoAI por sus siglas en idioma inglés. En ese contexto se han desarrollado herramientas para implementar soluciones a escala destinadas a la generación automatizada de datos, a través del desarrollo de algoritmos ajustados al problema a resolver o con modelos preentrenados.

Actualmente existen dos áreas focales –no las únicas- en las cuales los catastros pueden aprovechar los avances de la IA, el AA y el AP estas son: la teledetección y las valuaciones masivas. Comenzando por la primera, se aclara que el término teledetección es utilizado con alcance a las imágenes digitales provistas a través de diferentes plataformas: drone, avión y satélite. Los principales programas comerciales y libres disponen de herramientas GeoAI para la realización de diferentes operaciones, a continuación veremos someramente cuales son las variantes utilizadas.

El proceso de extracción de información a partir de imágenes tiene cuatro variantes o ramas: la segmentación semántica, la detección de objetos, la segmentación de instancias y la clasificación. La primera se utiliza para dividir una imagen en un conjunto de clases, siendo los mapas de uso y cobertura del suelo su producto típico. Todos los píxeles que componen una imagen se asignan a una de varias clases, por ejemplo, cuerpos de agua, bosques, cultivos, áreas urbanizadas, etc. En cambio la detección de objetos utiliza las características y coordenadas del entorno para definir un tipo de objeto del resto de la imagen, por ejemplo, los edificios. La segmentación de instancias constituye un híbrido entre las técnicas de segmentación semántica y detección de objetos. El objetivo de la clasificación de imágenes -históricamente asociada a la teledetección- es el mismo que el de la segmentación semántica y tiene dos métodos: supervisada y no supervisada. A través de la primera es posible decidir las clases a asignar a los píxeles, en tanto que en la segunda se deja a criterio del clasificador automatizado que clases estarán presentes en la imagen.

La detección de objetos

es la operación que resulta de interés particular para los catastros y la

veremos a través de un ejemplo práctico. Mapflow

es un complemento (plugin) para

QGIS, que desde imágenes seleccionadas de un proveedor en la web o de la carga

de una propia, permite extraer edificios, caminos, bosques y construcciones

(obras en ejecución). La operación es sencilla, primero hay que indicar el área

de interés (AOI) y seleccionar el modelo de IA que detectará los contornos de

los objetos y los digitalizará automáticamente. Una vez finalizado el

procesamiento, los resultados pueden ser descargados como una capa SIG

vectorial, que es posible editar para ajustar los errores que se hayan

observado a partir de una inspección visual.

Ejemplo de procesamiento en zona perirubana con modelo Buildings (Aerial Imagery) Fuente: https://docs.mapflow.ai/userguides/pipelines.html#id4

Mapflow dispone de

la opción Buildings con la cual es

posible extraer los polígonos correspondientes a los techos de los edificios

tomando como base imágenes satelitales de alta resolución de 50 cm. de píxel.

Se utilizan tres modelos diferentes para distintas regiones geográficas para

adaptarse mejor a los entornos urbanos del mundo, la decisión es automática

según la ubicación del AOI. Adicionalmente Buildings

(Aerial Imagery) realiza la misma

operación pero a partir de imágenes aéreas de 10 cm. de píxel (esta opción no

es gratuita). A través de la opción Roads

se pueden capturar los ejes de calles y caminos. Sobre estos últimos dos modelos

debe señalarse que son más adecuados para aplicar a zonas periurbanas y rurales

(Mapflow, s/f).

Algunas empresas como ESRI © y Picterra © disponen de aplicaciones que permiten entrenar modelos de AP para hacer una “sintonía fina” con el entorno en el que deben operar. Por ejemplo, no se puede esperar que un modelo obtenga resultados de buena calidad cuando fue entrenado con datos de una región tropical para imágenes de resolución media, cuando vamos a utilizarlo en la Patagonia con imágenes de alta resolución. De manera que los factores a considerar incluyen la región geográfica, el paisaje predominante, la estación, la resolución de las imágenes, los materiales constructivos, etc. Hay situaciones que requerirán la creación de un modelo desde cero o bien ajustar el modelo existente con nuevos datos para mejorar sus resultados. Si el modelo de IA que estamos utilizando no identifica adecuadamente los objetos de nuestro interés, es necesario entrenar un nuevo modelo para ajustarlo a nuestros requerimientos de manera tal de obtener resultados más alineados con nuestro entorno de trabajo.

Con esto queremos decir que los procedimientos automatizados de obtención de vectores a partir de imágenes, como la extracción de huellas de edificios, se trata de un reconocimiento complejo que demanda adecuaciones para los algoritmos dadas las propiedades geométricas y espectrales del objeto, junto a otras características de detalle como bordes, esquineros y sombras asociadas a los edificios. La operación para la extracción automática de edificios y otros objetos, es en definitiva una tarea abierta a la investigación que se inscribe en la actualización y modernización catastral, en la cual los algoritmos de AP resultan los más prometedores para superar las dificultades de extraer características semánticas de escenas complejas y grandes diferencias en la apariencia de los edificios (Jovanovic, D., et. al., 2021). Luego sigue el proceso para recoger sus atributos o características constructivas, para lo cual hay que realizar inspecciones en el terreno combinadas con recursos provenientes de la aplicación Google Street Wiew. Respecto al tratamiento de las alturas de los edificios, es posible recurrir a modelos digitales de elevaciones obtenidos a partir de vuelos con drone, vuelos fotogramétricos tradicionales o imagenes satelitales de alta resolución en modo estereoscópico.

La detección de cambios es otra técnica muy importante en el ámbito del catastro, ya que permite monitorear y gestionar las altas, bajas y modificaciones en el ambiente construido, a partir de una interpretación de imágenes tomadas en distintas fechas sobre la misma área y así obtener los objetos que han cambiado en un determinado período temporal e incorporarlos a la base de datos catastrales. Las operaciones de AP permiten realizar análisis multitemporales para detectar cambios en los elementos de interés y producir como resultado una salida con los cambios observados.

La otra área en la que la IA viene demostrando realizar un aporte significativo es en el de las valuaciones masivas que, respecto a los métodos utilizados tradicionalmente por los catastros, hacen una diferencia en cuanto a costo, eficiencia, velocidad y mantenimiento.

En la provincia de Córdoba, se viene aplicando desde hace 6 años una metodología para obtener los valores catastrales de más de dos millones de inmuebles urbanos y rurales, mediante la aplicación técnicas algorítmicas cuyas ventajas son su capacidad de manejar grandes volúmenes de datos, el elevado nivel de predicción, así como la factibilidad de sostener y repetir este tipos de estudios periódicamente (Scardino, L., 2023). En este mismo sentido, aunque con distintas herramientas de AA respecto al caso de Córdoba, se ha documentado un caso práctico en tres localidades de la provincia de Mendoza (Polo, R. E., et. al., 2023).

La aplicación de la técnica de AA y de su especialización el AP para la elaboración de modelos predictivos, está subordinada a dos insumos fundamentales: 1) los datos observados o de referencia o variables dependientes, y 2) los elementos que contribuyen a la explicación de los valores observados o variables independientes. El primero requiere disponer de un gran volumen de datos sobre el precio de la tierra urbana y rural del mercado inmobiliario; en tanto que el segundo necesita de parámetros que tienen que ver con el contexto, con las características zonales y tipo de bienes, con el acceso a servicios públicos, zonas comerciales y transporte en las áreas urbanizadas; y con la capacidad productiva, la distancia a rutas, distancia a fuentes de agua y distancia a centros de acopio en las áreas rurales. Las variables señaladas son solo ejemplos, pudiendo variar algunas de acuerdo a la jurisdicción, legislación vigente y mercado en que se apliquen.

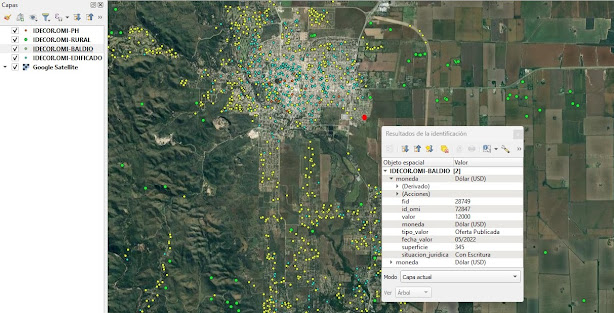

Los algoritmos se

entrenan con los datos observados que representan valores cuantitativos y

cualitativos del mercado que se administran en el Observatorio del Mercado

Inmobiliario (OMI), y con las variables explicativas del valor determinadas a

través de análisis espaciales en un SIG, a fin de establecer las relaciones

matemáticas que existen entre ambos conjuntos de datos para extraer

conocimiento de ellas. Una vez establecidas estas relaciones, se evalúa la

calidad de los resultados y se iteran los procesos para ajustar los valores de

salida respecto a los valores observados, para arribar a los valores unitarios

probables interpolados y volcados en un mapa continuo del territorio.

Debe considerarse que cualquier cambio o transformación que se decida emprender para aplicar métodos de valuación masiva automatizada basados en la IA u otros métodos, requiere la disponibilidad de un adecuado volumen de muestras representativas para desarrollar modelos que ofrezcan resultados confiables y de calidad. Es que toda valuación debe partir de los datos observados porque son los que en definitiva contribuyen a dar forma al conocimiento de cómo se comporta un mercado inmobiliario. Aunque no siempre sea posible obtener muestras sobre todo el universo de inmuebles y distribuidas homogéneamente en todo el territorio, y aún cuando determinados algoritmos pueden realizar una gestión robusta del modelo con datos de entrada faltantes, el OMI es el primer gran paso que hay que dar, tarea para la cual se debe valorar y calibrar el esfuerzo organizativo, técnico-administrativo y de sostenibilidad que sobreviene a su implementación.

Datos del Observatorio del Mercado Inmobiliario (OMI) de la Provincia de Córdoba. Fuente: https://www.mapascordoba.gob.ar/#/geoservicios

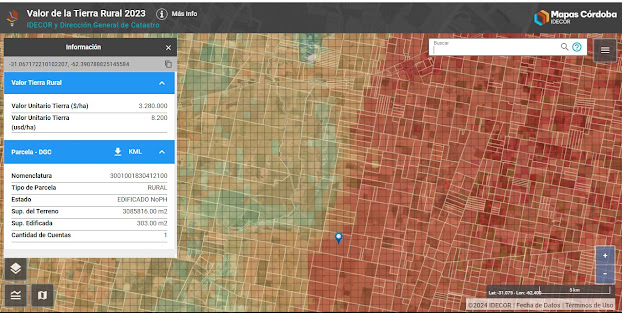

Mapa de valor de la

Tierra Rural 2023. Fuente: https://mapascordoba.gob.ar/viewer/mapa/469

Para concluir, y como comentario general podemos decir que la adopción de las herramientas descritas requiere un rediseño de los procesos de trabajo que permitan adaptarlos al funcionamiento de la organización, siempre con vista a obtener una ventaja comparativa desde el punto de la eficiencia, calidad de resultados y agilidad en los procesos de gestión y mantenimiento de datos. Por otro lado, es fundamental realizar controles sobre la confiabilidad de los modelos de IA utilizados, para lo cual es necesario realizar evaluaciones cualitativas de los resultados para identificar eventuales deficiencias y aspectos de mejora.

Gobierno de la IA

En términos generales, el tema está relacionado con la ética en los usos y aplicaciones de las tecnologías relacionadas con la IA, y en particular se encuentra referido al conjunto de prácticas, procesos y herramientas que contribuyen a que una organización utilice la IA de forma transparente y confiable, tratándose por ello de un requisito indispensable para implementar soluciones funcionales y operativas. De esta manera es fundamental considerar que para incorporar satisfactoriamente el uso de la IA en una organización, se deban atender los siguientes aspectos:

- Trazabilidad, lo que implica poder rastrear desde el origen los datos de referencia, el modelo de IA y su idoneidad para abordar el problema en tratamiento, y la forma en que se evalúa la calidad de los resultados obtenidos.

- Explicabilidad, que está en relación con la capacidad de la organización para explicar cómo y porqué el modelo de IA llega a los resultados que produce. Dicho con otras palabras, es imprescindible tener el control sobre la manera en que se llega a resultado determinado, lo que significa poner luz en la caja negra del procesamiento algorítmico, es decir en su interpretabilidad. Esta cuestión es particularmente relevante para los métodos de valuación masiva basados en la IA.

- Supervisión, la organización debe tener el control de todos los procesos automatizados y de supervisar en forma permanente los resultados obtenidos, para aplicar las correcciones a los datos o al modelo de IA en caso de que se obtengan resultados sesgados o errores sistemáticos y/o errores atípicos.

- Responsabilidad, en las tareas de producción con modelos de IA se requiere que cada proceso tenga una persona responsable, de modo de asegurar el control y la prevalencia de las decisiones humanas.

- Normatividad, las organizaciones deben regular formalmente la ética en relación al uso de la IA sobre los aspectos mencionados precedentemente. Asimismo es recomendable incluir en la normativa todo lo relacionado al registro de cambios en las herramientas tecnológicas de la IA y en el tratamiento y manejo de incidentes y riesgos.

En definitiva, todas estas medidas resultan oportunas para establecer diferencias entre la ejecución atribuida a la autonomía decisional de los algoritmos, y la responsabilidad humana, hecho que parte de concebir a la IA como una cosa, un medio artificial para conseguir objetivos humanos pero que no deben confundirse con una persona humana. Es decir, el algoritmo puede ejecutar, pero la decisión debe necesariamente recaer sobre la persona y por lo tanto, también la responsabilidad (Rep. Argentina, Jefatura de Gabinete de Ministros, Secretaría de Innovación Pública, 2023). Esto de ningún modo significa actuar con recelo frente a la IA, sino que debemos mantenernos reflexivos sobre su gestión e impacto y nunca dejar de ejercer nuestro sentido crítico.

Referencias:

(*) Datos

estructurados: son aquellos que requieren de la intervención humana para

etiquetarlos, tales como las construcciones o edificios, rutas, calles, etc., y

así puedan ser reconocidos por el algoritmo.

(**) Datos no

estructurados: son aquellos que intervienen en el entrenamiento del modelo de

AP para identificar los objetos de interés a través de las capas de la red

neuronal para obtener identificadores que permitan clasificar dichos objetos.

Fuentes consultadas y referencias:

Chornyi, Andrii (2023). Deep Learning vs. Machine Learning, https://codefinity.com/blog/Deep-Learning-vs-Machine-Learning

IBM (a) (s/f). What is Data Science?, https://www.ibm.com/topics/data-science

IBM (b) (s/f). ¿Qué es la segmentación semántica?, https://www.ibm.com/es-es/topics/semantic-segmentation

IBM (c) (s/f). ¿Qué es la segmentación de instancias?, https://www.ibm.com/es-es/topics/instance-segmentation

Jovanovic, D.; Gavrilovic, M.; Sladic, D.; Radulovic, A.; Govedarica, M. (2021). Building Change Detection Method to Support Register of Identified Changes on Buildings,https://www.mdpi.com/2072-4292/13/16/3150

Polo, R. E.; Alberdi, R. & Erba, D. A. (2023). Aplicación de técnicas de Machine Learning para Valuación Masiva de Inmuebles en ciudades intermedias de la provincia de Mendoza, https://www.repositorio.umaza.edu.ar/icu/article/view/428. Revista ICU. Investigación, Ciencia y Universidad (ICU), Vol. 7 Núm. 9 (2023): N° 9, pp. 74-86.

Real Academia Española (2023). Diccionario de la lengua española. Edición tricentenario. Actualización 2023, https://dle.rae.es/inteligencia?m=form#2DxmhCT

República Argentina. Jefatura de Gabinete de Ministros. Secretaría de Innovación Pública (2023). Recomendaciones para una Inteligencia Artificial Fiable, https://www.argentina.gob.ar/sites/default/files/2023/06/recomendaciones_para_una_inteligencia_artificial_fiable.pdf

Scardino, L. (2023). Aplican «machine learning» para la valuación fiscal de los inmuebles en Córdoba, https://unciencia.unc.edu.ar/computacion/aplican-machine-learning-para-la-valuacion-fiscal-de-los-inmuebles-en-cordoba/. En Universidad Nacional de Córdoba, UNCiencia.